做移动端网站设计最近有哪些新闻

目录

引言

一、神经网络概述

1 定义

2 基本原理

二、得分函数

1 定义

2 应用方法

3 与神经网络

三、损失函数

1 定义

2实现方法

3 与神经网络

四、得分函数与损失函数的协同作用

1 关系

2 实际应用

六、代码事例

、总结与展望

引言

在人工智能与机器学习的浪潮中,神经网络已经成为了一种至关重要的技术。它以其独特的结构和机制,模拟了人脑神经元的运作方式,从而实现了对复杂数据的处理与分析。在神经网络的运行过程中,得分函数和损失函数扮演了至关重要的角色,它们共同构成了神经网络学习和优化的基础。

一、神经网络概述

1 定义

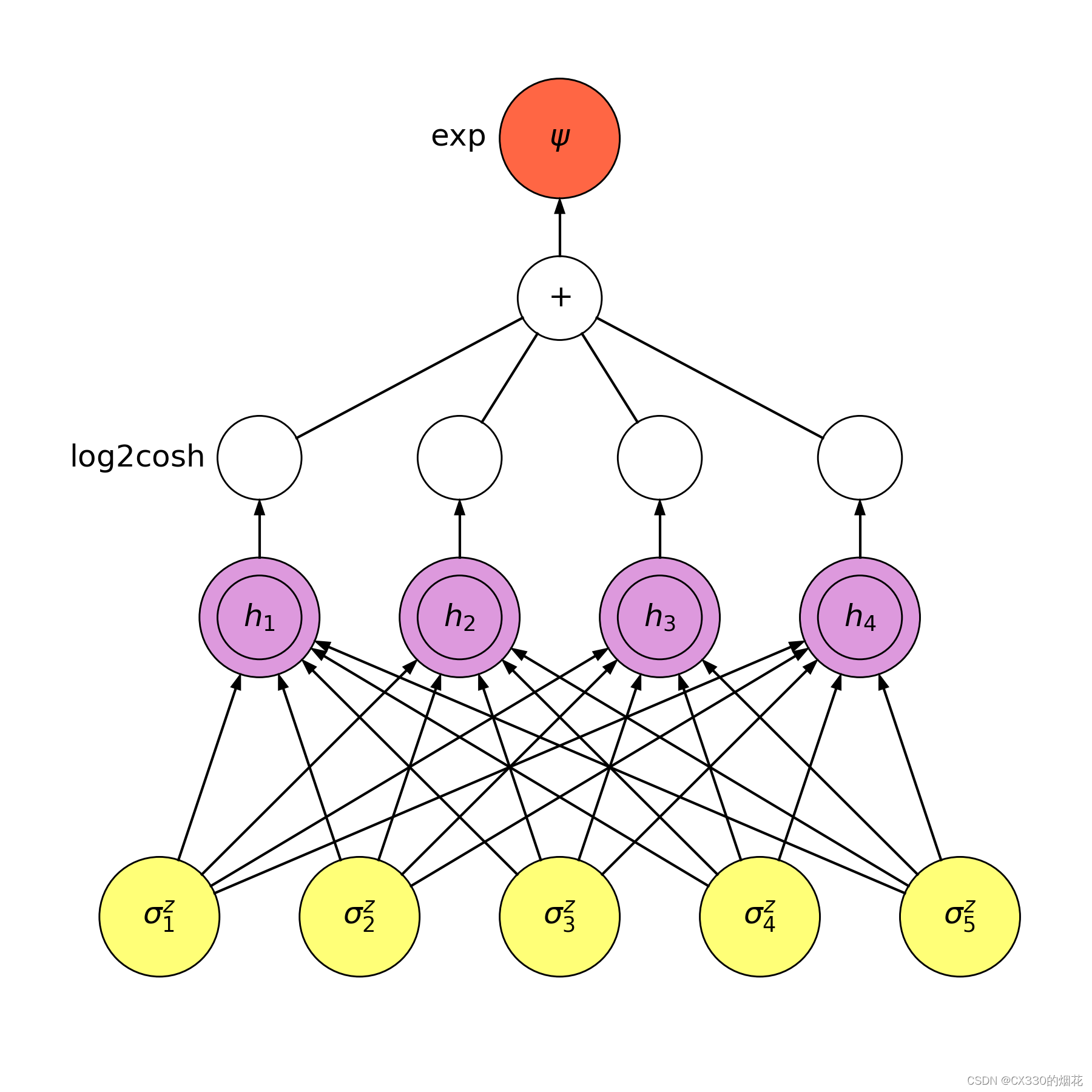

神经网络是一种模拟人脑神经元结构的计算模型,它通过大量的神经元之间的连接和交互,实现了对输入信息的处理和学习。神经网络的基本组成单元是神经元,每个神经元接收来自其他神经元的输入信号,经过加权求和和激活函数的处理后,产生输出信号。

2 基本原理

通过不断调整神经元之间的连接权重,神经网络可以实现对复杂函数的逼近和学习。

二、得分函数

1 定义

得分函数是神经网络对输入数据进行预测和表达的关键工具。在神经网络的输出层,得分函数将网络的内部表示转化为具体的预测值或分类结果。对于不同的任务和数据类型,得分函数的形式和计算方式也会有所不同。

2 应用方法

在分类任务中,得分函数通常表现为一个线性组合或非线性映射,它将网络的输出转换为每个类别的得分或概率。通过比较不同类别的得分,我们可以确定输入数据所属的类别。在回归任务中,得分函数则直接输出预测值,如房价、股票价格等连续变量。

3 与神经网络

得分函数的设计对于神经网络的性能至关重要。一个合适的得分函数应该能够充分表达数据的内在规律和特征,同时易于优化和计算。在实际应用中,我们需要根据具体任务和数据特点来选择合适的得分函数。

三、损失函数

1 定义

损失函数是神经网络训练过程中的另一个核心组件。它衡量了神经网络的预测值与实际值之间的差距,为优化算法提供了指导方向。损失函数的选择对于神经网络的训练效果和泛化能力具有重要影响。

2实现方法

常见的损失函数包括均方误差损失(用于回归任务)、交叉熵损失(用于分类任务)等。这些损失函数根据不同的任务需求和数据特点设计,旨在最小化预测值与实际值之间的误差。

3 与神经网络

在神经网络的训练过程中,我们通过反向传播算法和梯度下降等优化算法来不断调整网络参数,以最小化损失函数的值。这一过程需要反复迭代多次,直到损失函数收敛到一个较小的值或达到预设的迭代次数。

通过选择合适的损失函数和优化算法,我们可以使神经网络在训练过程中不断逼近真实的数据分布和规律,从而提高其预测性能和泛化能力。

四、得分函数与损失函数的协同作用

1 关系

得分函数和损失函数在神经网络中发挥着协同作用。得分函数负责将网络的内部表示转化为具体的预测值或分类结果,而损失函数则衡量这些预测值与实际值之间的差距。通过不断优化损失函数的值,我们可以使神经网络的预测性能得到不断提升。

2 实际应用

在实际应用中,我们需要根据具体任务和数据特点来选择合适的得分函数和损失函数。同时,我们还需要注意得分函数和损失函数之间的相互影响和制约关系,以确保神经网络的训练和预测过程能够顺利进行。

六、代码事例

下面是一个更详细的神经网络、得分函数和损失函数的代码示例。我们将使用Python的深度学习库PyTorch来构建一个简单的神经网络,用于解决二分类问题。

首先,我们需要安装PyTorch

import torch

import torch.nn as nn

import torch.optim as optim

import torch.nn.functional as F# 定义神经网络模型

class SimpleNeuralNet(nn.Module):def __init__(self, input_size, hidden_size, num_classes):super(SimpleNeuralNet, self).__init__()self.fc1 = nn.Linear(input_size, hidden_size)self.relu = nn.ReLU()self.fc2 = nn.Linear(hidden_size, num_classes)def forward(self, x):out = self.fc1(x)out = self.relu(out)out = self.fc2(out)return out# 初始化模型参数

input_size = 784 # 假设输入为28x28的图像,展平后为784个特征

hidden_size = 128 # 隐藏层大小

num_classes = 2 # 类别数,例如二分类问题model = SimpleNeuralNet(input_size, hidden_size, num_classes)# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss() # 交叉熵损失函数,用于分类问题

optimizer = optim.Adam(model.parameters(), lr=0.001) # 使用Adam优化器# 假设我们有一些输入数据X和目标数据y

# X是形状为(batch_size, input_size)的输入特征矩阵

# y是形状为(batch_size,)的目标类别向量# X, y = ... (此处需要您提供或加载数据)# 为了简化,这里我们模拟一些随机数据来演示训练过程

batch_size = 64

X = torch.randn(batch_size, input_size)

y = torch.randint(0, num_classes, (batch_size,))# 训练模型

num_epochs = 10

for epoch in range(num_epochs):# 前向传播outputs = model(X)loss = criterion(outputs, y)# 反向传播和优化optimizer.zero_grad() # 清空梯度loss.backward() # 反向传播计算梯度optimizer.step() # 使用优化器更新权重if (epoch+1) % 5 == 0:print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item()}')# 得分函数就是模型的输出

# 在这里,outputs就是得分函数的结果,它包含了每个类别的原始得分(logits)

# 如果需要概率分布,可以使用softmax函数

probs = F.softmax(outputs, dim=1)

print(probs)# 损失函数用于计算模型预测与真实标签之间的差距

# 在这个例子中,我们使用了交叉熵损失函数

print(f'Loss for the current batch: {loss.item()}')

在这个示例中,我们定义了一个简单的全连接神经网络,它有一个隐藏层和一个输出层。输出层的输出(outputs)就是得分函数的结果,它表示模型对每个类别的原始得分。通过应用softmax函数,我们可以将这些原始得分转换为概率分布。

损失函数(criterion)用于计算模型预测的概率分布与真实标签之间的差距。在训练过程中,我们反复执行前向传播、计算损失、反向传播和参数更新的步骤,以最小化损失函数并优化模型的性能。

请注意,这个示例是为了演示神经网络、得分函数和损失函数的概念而编写的,并且使用了模拟数据。在实际应用中,你需要加载和处理真实的数据集,并根据问题的具体要求进行模型的调整和优化。

、总结与展望

神经网络、得分函数与损失函数构成了深度学习的核心组件。它们共同实现了对复杂数据的处理、学习和优化。随着技术的不断发展,我们相信神经网络将在更多领域得到应用和发展,为人类带来更多的便利和创新。

然而,我们也应该意识到神经网络仍存在一些挑战和问题。例如,如何设计更有效的得分函数和损失函数以提高神经网络的性能?如何避免过拟合和欠拟合等问题以提高神经网络的泛化能力?这些问题需要我们进一步深入研究和探索。

总之,神经网络、得分函数与损失函数是深度学习中不可或缺的重要组成部分。它们为我们提供了一种强大的工具来处理和分析复杂数据,为我们打开了通向智能世界的大门。在未来,我们将继续探索和完善这些技术,为人类社会的进步和发展做出更大的贡献。