php做的大型网站磁力神器

一、说明

欢迎来到我们对不断发展的自然语言处理 (NLP) 领域的探索的第 8 章。在本期中,我们将重点介绍一项重塑 NLP 格局的突破性创新:Transformers。在我们之前对 seq2seq 模型、编码器-解码器框架和注意力机制的讨论之后,我们现在开始了解 Transformer 如何彻底改变语言任务的方法。

以下是本章的内容:

- 变压器模型的出现:了解 Transformer 的起源,以及它们如何标志着 LSTM 和 GRU 等传统递归神经网络模型的重大转变。

- 了解 Transformer 架构: 深入了解 Transformer 的复杂架构,探索其独特的组件,例如编码器-解码器模块、自注意力机制、位置编码、前馈网络、层归一化和残差连接。

- 与传统模型(LSTM、GRU、seq2seq)的比较:深入了解 Transformer 在处理效率和处理复杂语言任务方面有何不同并超越传统模型。

- 变压器的实际应用和影响: 探索这些模型在各种 NLP 应用(如机器翻译、文本摘要、问答系统和情感分析)中的变革性影响。

加入我们,我们将揭示 Transformer 模型的复杂性和功能,提供理论见解和实际应用的融合

二、变压器模型的出现

Vaswani 等人在 2017 年的关键论文“Attention is All You Need”中介绍了 Transformer 模型,它标志着与以前占主导地位的基于递归神经网络的模型(如 LSTM(长短期记忆)和 GRU(门控循环单元))的背离。这些模型是许多 NLP 应用程序的支柱,但具有固有的局限性,特别是在处理长序列和并行处理数据方面。

变压器的出现是为了解决这些限制。它们的架构与它们的前辈有着根本的不同,允许并行处理整个数据序列。这种转变不仅提高了处理效率,而且为处理大规模语言数据开辟了新的途径,这在涉及理解文本中的上下文和关系的任务中尤为关键。

三、了解 Transformer 架构

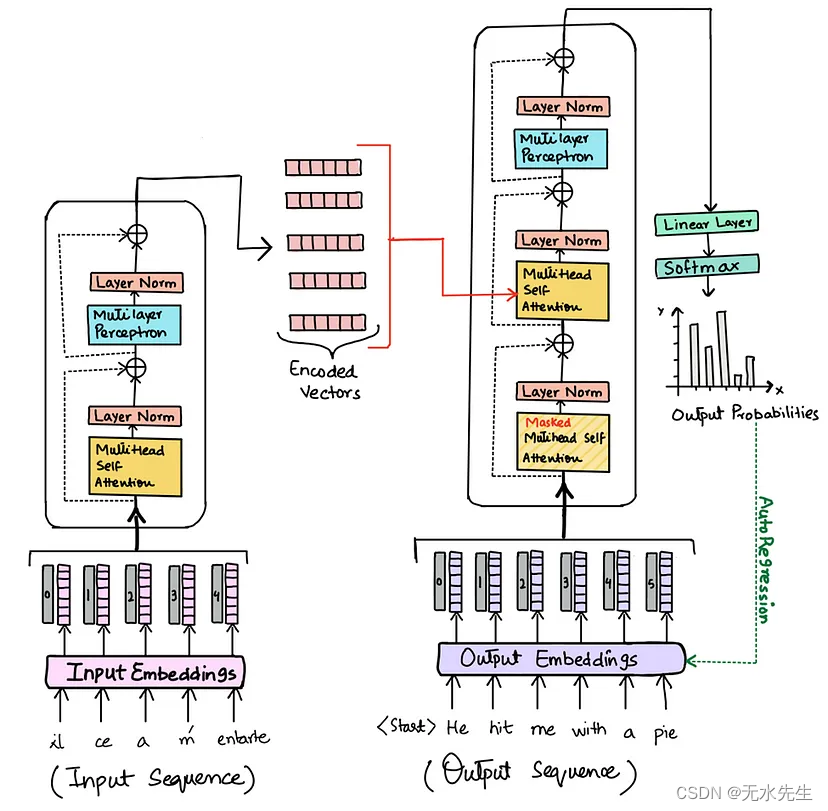

变形金刚的结构既复杂又巧妙。它由几个组件组成,这些组件协同工作以有效地处理语言数据:

-

编码器和解码器模块

变压器由多个相互堆叠的编码器和解码器块组成。这种结构与传统的 seq2seq 模型有很大不同,后者通常具有单个编码器和单个解码器。 -

自注意力机制

变形金刚的核心创新是自注意力机制。这允许编码器中的每个位置都处理编码器上一层中的所有位置。同样,解码器中的每个位置都可以处理解码器中直到该位置的所有位置以及编码器中的所有位置。这种机制允许模型权衡输入数据不同部分的重要性,从而能够对数据中的上下文和关系进行细致入微的理解。 -

位置编码

由于 Transformer 不按顺序处理数据,因此它们缺少有关序列中单词顺序的信息。位置编码被添加到输入嵌入中以提供此位置信息,使模型能够理解单词的序列。 -

前馈神经网络

每个编码器和解码器模块都包含一个完全连接的前馈网络。该网络处理注意力层的输出,每层都有自己的参数。 -

层归一化和残余连接

这些元素对于稳定和加速 Transformer 模型的训练至关重要。层归一化有助于在将每个子层的输出传递到下一层之前对其进行归一化,残差连接有助于避免训练期间的梯度消失问题。

四、与传统模型(LSTM、GRU、seq2seq)的比较

Transformers 与 LSTM、GRU 和 seq2seq 模型等传统模型之间的一个关键比较在于它们处理数据的方法。LSTM 和 GRU 模型擅长从序列中捕获信息,但要按顺序捕获信息。这种顺序处理意味着这些模型可能会与文本中的长期依赖关系作斗争,因为信息必须通过序列中的每个步骤。

Seq2seq 模型通常用于机器翻译和其他类似任务,通常由编码器和解码器组成。虽然有效,但它们也按顺序处理信息,并且可能会遇到文本中的长序列和复杂关系。

Transformer 通过并行处理整个数据序列来克服这些挑战。这种并行处理能力显著提高了模型的效率及其处理复杂语言任务的能力。变形金刚中的自我注意力机制可以更细致地理解文本中的上下文和关系,这在语言翻译、摘要和问答系统等任务中特别有价值。

五、变压器的实际应用和影响

Transformer 模型的引入对各种 NLP 任务产生了重大影响。它们能够有效地处理和理解复杂的语言数据,从而在各种应用程序中带来了实质性的改进,包括但不限于:

机器翻译:Transformers 在机器翻译方面取得了最先进的成果,比以前的模型更有效地处理多种语言和复杂的句子结构。

文本摘要:他们理解文本中的上下文和关系的能力使 Transformers 在准确总结长文档方面特别有效。

问答系统:Transformer 提高了系统理解和响应自然语言查询的能力,使其更加准确和高效。

情感分析:它们增强了理解语言细微差别的能力,从而在文本中进行更准确的情感分析。

六、结论

在这篇博客中,我们探讨了 Transformer 模型在 NLP 中的变革性影响。这些模型代表了从顺序处理到并行处理语言数据的范式转变,能够更高效地处理复杂任务。

随着我们在本系列中的推进,下一章将重点关注“BERT 和迁移学习”。我们将深入探讨来自转换器的双向编码器表示 (BERT) 模型如何彻底改变 NLP 中的迁移学习。我们将探讨针对特定任务微调 BERT 的概念及其在各种 NLP 挑战中的影响。这将为我们最终讨论大型语言模型 (LLM) 奠定基础,包括 GPT 变体,以及它们在塑造 NLP 未来中的作用。请继续关注 Transformer 的高级应用及其在语言处理领域的变革力量的深刻旅程。